O reconhecimento facial não só traz a possibilidade de instaurar uma vigilância em massa, mas também contém uma tendência preconceituosa contra certos grupos de nossas sociedades – com as mulheres negras sendo as mais afetadas.

A difusão de novas tecnologias facilita o nosso cotidiano de muitas maneiras. Contudo, essas tecnologias, juntamente com a massa de dados coletados tanto pelos governos quanto por empresas privadas e os fluxos de dados permanentes, criaram ferramentas não só com potencial de vigilância em massa, mas também de exclusão e repressão. O reconhecimento facial é um exemplo de tecnologia com potencial para isso. A tecnologia per si não é nova, mas acapacidade de processamento, a diminuição dos custos para seu desenvolvimento, acompanhado do avanço da inteligência artificial, estão permitindo a sua proliferação ampla em várias áreas de aplicação. Hoje empresas e universidades como a Microsoft e a Stanford armazenam milhões de imagens de faces de pessoas no mundo em seus bancos de dados, alimentando tecnologias de reconhecimento facial.

Uso no Metrô de São Paulo é considerado controverso

Aqui no Brasil, esta tecnologia passou a ser mais discutida a partir de abril de 2018 quando um sistema de reconhecimento facial foi instalado na linha vermelha do Metrô de São Paulo. O sistema mudava anúncios exibidos aos passageiros conforme suas expressões faciais. Era possível detectar idade e sexo e classificar as emoções nas categorias feliz, insatisfeito, surpreso ou neutro. Desenvolvido pela empresa Via Quatro, o projeto foi implementado em conjunto com a LG, companhia multinacional de eletrônicos que forneceu as telas, e com a Hypera Pharma, uma grande empresa farmacêutica brasileira. Críticas como a de Jacqueline Abreu, coordenadora da área de Privacidade e Vigilância da InternetLab, publicada em um artigo no Vice, site estadunidense-canadense de cultura, contestam a iniciativa por ser uma forma de “interceptação ambiental com processamento automático de dado pessoal sensível, feita sem base jurídica por concessionária de serviço público para a exploração de terceiros”. A tecnologia parou de ser utilizada após uma ação civil do Idec (Instituto Brasileiro de Defesa do Consumidor) contra a Via Quatro. A Justiça decidiu, devido à falta de consentimento dos passageiros, que a operadora cessasse essa coleta de dados sob risco de multa diária de R$50 mil, em caso de descumprimento.

Por outro lado, há casos considerados positivos: a utilização de um sistema de reconhecimento facial nos ônibus de São Paulo bloqueou mais de 331.000 Bilhetes Únicos. Eles estavam sendo utilizados por terceiros que usavam os benefícios da gratuidade para idosos e pessoas com deficiência, além do desconto na tarifa para estudantes.

Em julho de 2019, o Metrô de São Paulo reapareceu no noticiário ao instalar um novo sistema de monitoramento, aumentando o parque de câmeras extensivamente e dessa vez com a opção de vincular o sistema aos bancos de dados da Secretaria de Segurança Pública para perseguição de foragidos da Justiça[i]. Segundo o presidente da companhia do Metrô Silvani Pereira, o sistema oferece muitas vantagens, por exemplo, possibilitaria ajudar a buscar crianças perdidas que estão circulando sozinhas no Metrô ou também faria parte da segurança antiterrorista por detectar objetos suspeitos.

Ameaças a liberdade e democracia

Essas coletas de dados biométricos sem consentimento provocaram muitas críticas por setores da sociedade civil. A maioria das críticas se baseia no argumento de que os custos sociais e de liberdade desse tipo de vigilância pesam mais que a segurança que ela pode promover. Não é dificil duvidar que haja realmente uma crise de segurança no Metrô para justificar o uso desse meio. O uso de fotografia de rostos de pessoas tem grande uso na história para a busca de criminosos e não apresentava questões éticas. Por outro lado a tecnologia de reconhecimento facial está ligada a bancos de dados gigantes que possibilitam não só um uso em processos criminais, mas como uma vigilância em massa, na qual não há diferenciação de quem está sendo monitorado. Essa ferramenta nas mãos de um governo com interesses questionáveis pode servir para instaurar controle sobre inimigos políticos, dissidentes ou outras pessoas não alinhadas com a política no poder.

O que são dados biométricos ?

Cada pessoa nesse planeta tem atributos fisiológicos únicos como DNA, impressão digital, íris, cheiro ou a maneira como a pessoa anda, a voz e também a distância entre certos pontos do rosto. Se essas informações forem gravadas, falamos sobre dados biométricos. Devido a seu caráter único, dados biométricos podem identificar pessoas sem necessidade de nomes ou cartas de identificação. Hoje, a tecnologia biométrica já chegou em nosso cotidiano e se tornou comum, por exemplo, ao desbloquear seu smartphone. Os fabricantes afirmam que a autenticação de dados biométricos é mais segura que as senhas tradicionais. Por outro lado, a tecnologia provoca perigos já que é fácil fazer uma cópia de uma impressão digital ou gravação de voz.O caso da China pode ser um exemplo. O regime comunista instaurou um sistema de “crédito social”, que nada mais é do que o uso de tecnologia de vigilância nas mãos de um governo. Na China todas as pessoas registradas pelas câmeras de reconhecimento facial, do sistema chamado SkyNet, quando se movem no espaço público são avaliadas com notas de acordo com seu comportamento cívico. Consequentemente, enfrentam penalidades ou recebem privilégios. Pagamento de multas, dívidas e infrações civis, mesmo até fumar em local público proibido são incluídos na avaliação, feita por algoritmos cujo código não é conhecido pelo público. Em caso de uma pontuação baixa, que significa uma “baixa confiabilidade” do cidadão, pode levar, por exemplo, a proibir uma pessoa de viajar de avião ou trem. O caso da China mostra como o reconhecimento facial pode contribuir com governos autocráticos para instaurar um controle social que viola o direito à privacidade. Deste modo, o reconhecimento facial usado no Metrô de São Paulo também poderia fazer com que ativistas, políticos ou pesquisadores críticos tivessem que evitar esses lugares.

Assim, produzir-se-ia um efeito de controle social tóxico para a democracia. Por tudo isso, o reconhecimento facial pode ser visto como ameaça à sociedade civil limitando o direito à privacidade, à liberdade de movimento,de reunião e associação, pilares dos Direitos Humanos[1]. Em suma, é necessário pôr a questão. Este tipo de tecnologia pode dar a policiais em delegacias o poder de identificação de quem participa de protestos, comícios políticos, reuniões de igreja ou até dos Alcoólicos Anônimos.

Índices de erro

Uma outra crítica presente é como usar o reconhecimento facial se esta tecnologia ainda tem índices de erro alto.Um estudo independente de dois pesquisadores da Universidade de Essex sobre o uso de reconhecimento facial em Londres, realizado entre junho 2018 e fevereiro 2019, por exemplo, mostrou números chocantes. O sistema operou com uma cota de sucesso de somente 19% e levou à detenção 42 pessoas e 8 pessoas procuradas pela polícia. Para alcançar esse resultado, o escaneamento de rostos de milhares de pessoas consideradas inocentes foi aceito. Segundo artigo da Wired, na final da UEFA Champions League, em 2017, um sistema de reconhecimento facial identificou 2.470 pessoas como criminosos dos quais somente 173 foram corretamente identificados. Isso significa um índice de erro de 92%. No Brasil, durante o carnaval carioca de 2019, as autoridades testaram um sistema com um índice de erro que ficou em 90%, segundo Joana Varon, fundadora da Coding Rights. Os dados coletados foram administrados pela Oi, empresa privada com histórico de ter sido multada por violações da privacidade de seus clientes. Esses índices de erro enfraquecem o argumento pró-reconhecimento facial de que a tecnologia aprimoraria a eficiência da polícia. Para ilustrar o problema dessa falta de precisão, podemos imaginar um outro serviço público como, por exemplo, uma ambulância com o mesmo índice de erro. Se você chamasse uma ambulância dez vezes e nove vezes, fosse um alarme falso, a indignação pública seria grande.

Viés e preconceitos nos algoritmos

Quando um sistema de reconhecimento facial foi testado no Metrô do Rio de Janeiro em julho de 2019, já no segundo dia a tecnologia falhou. Detectou uma mulher erroneamente como uma criminosa e em seguida ela foi encaminhada à delegacia em Copacabana. Além da falsa acusação, há algo importante neste caso:a vítima era uma mulher. Há outros casos nos quais os algoritmos de reconhecimento facial demonstraram que contêm viés e preconceitos contra mulheres e pessoas negras, principalmente, mulheres negras.

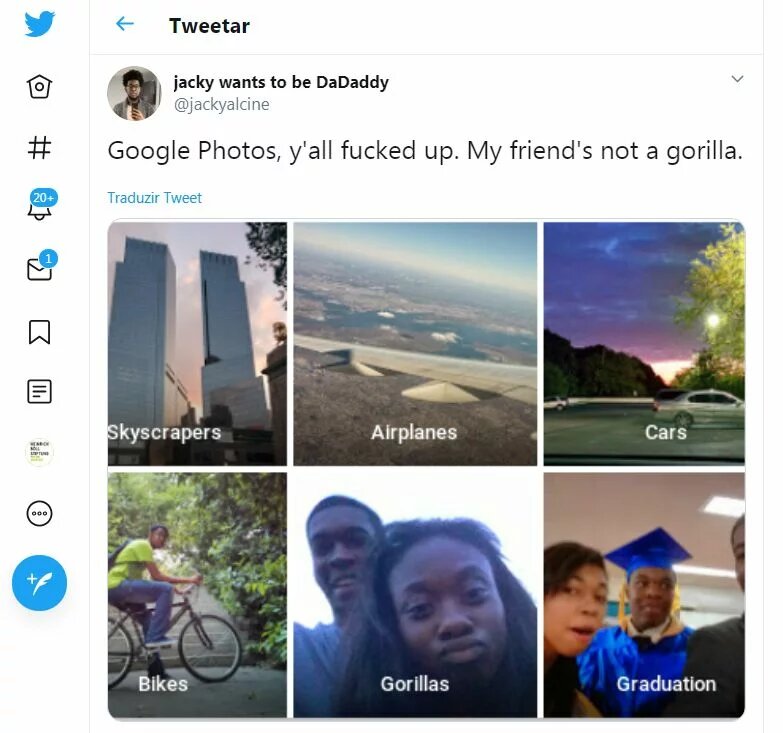

O caso do ativista do tema da tecnopolítica Jacky Alcinéé um dos exemplos desta questão.Em 2015, Jacky Alciné twittou que o aplicativo de fotos do Google nomeou automaticamente imagens dele e de sua namorada negra com a palavra "gorilas".

O caso despertou indignação pública e o Google reagiu imediatamente, dizendo que lamentava sinceramente o incidente. Jacky, ele próprio desenvolvedor de softwares, twittou: "Eu sei COMO isso aconteceu; Mas o problema também está em PORQUÊ.” O Google não tinha conseguido resolver o problema durante dois anos até que decidiu apagar a categoria “Gorilas”.

As pesquisas e publicações da pesquisadora do MIT Media Lab e ativista de tecnopolítica Joy Buolam Winichamam atenção para o viés preconceituoso nos algoritmos de reconhecimento facial contra mulheres negras. Ela testou a tecnologia de reconhecimento facial várias vezes e se tornou cética porque o software falhou em detectar sua face. Os programas de reconhecimento facial funcionam geralmente melhor com homens brancos. A identificação falsa de mulheres brancas acontece com uma a cada 10 mil vezes, enquanto com mulheres negras a confusão acontece com uma a cada mil vezes, sendo 10 vezes mais frequente, segundo um estudo de NIST (National Institute of Standards and Technology). O departamento de Segurança Interna dos Estados Unidos recentemente realizou testes da tecnologia em aeroportos,mostrando que peles mais escuras contavam com identificação menos precisa.

Consequências

Mas quais são as possíveis consequências disso? Uma delas é a probabilidade maior de mulheres, negras e grupos de minorias étnicas serem detectados erroneamente e abordados por autoridades para que se identifiquem. Essas pessoas teriam sido consideradas suspeitas apenas por causa das características físicas ou em outras palavras por causa de seus corpos. Consequentemente, mulheres negras e outros grupos socialmente vulneráveis poderiam estar sendo afetados desproporcionalmente pela automatização. Segundo um relatório sobre o uso de reconhecimento facial em Londres, o efeito de controle social se intensifica com grupos não brancos. O relatório conclui que 38% de pessoas entre 16 a 24 anos não iriam a eventos onde o reconhecimento facial fosse usado.

Embora seja importante descobrir tais preconceitos na programação, mesmo sistemas ditos mais justos não levariam necessariamente a mais justiça social, devido à desigualdade e discriminação já existente no sistema de persecução penal, como mostram as estatísticas criminais.O ponto é que a precisão e o preconceito de tecnologias, como o reconhecimento facial são apenas uma forma pela qual as comunidades marginalizadas experimentam uma discriminação nova e automatizada. Algoritmos de aprendizado de máquina usado pela perseguição penal podem ser alimentados de dados considerados racistas em virtude dos preconceitos.

Por exemplo, a população carcerária americana é majoritariamente negra e sistemas de reconhecimento facial usam fotos tiradas no momento da prisão, fazendo com que mais fotos de negros entrem em seus bancos de dados, como afirmado num estudo de 2017 do Law’s Center on Privacy and Technology da Universidade de Georgetown. Assim, a tecnologia agrava relações históricas de desigualdade, reforçando essas relações dentro dos algoritmos e, portanto, reforçariam esse viés nas instituições.

No ensaio do desenvolvedor de software Nabil Hassein, "Contra a inclusão negra no reconhecimento facial", publicado no blog Decolonized Tech, ele afirma: "Não vejo razão para apoiar o desenvolvimento ou uso de tecnologias que facilitem o estado, categorizar e monitorar membros da minha comunidade.” Nesse contexto a questão fundamental é que a inprecisão e o viés de tecnologias como o reconhecimento facial são apenas uma maneira pela qual comunidades marginalizadas experimentam uma nova discriminação automatizada. Os propósitos para os quais o reconhecimento facial é desenvolvido e a forma como é usado principalmente estão intimamente ligados às injustiças sistêmicas e suas institucionalizações.

Há também outros casos em que a tecnologia tem sido travestida da ideia de agilidade. A partir de 2018, os passageiros que voam de Dubai com a cia Emirates não precisam mais fazer fila nos controles de passaporte ou e-gates. É possível passar de forma fácil e conveniente por um túnel que exibe imagens bonitas de alta resolução como, por exemplo, um aquário e está equipado com 80 câmeras que escaneiam o rosto e a íris. O design do túnel incentiva os viajantes a olharem em volta, para que a tecnologia possa capturar seu rosto com mais precisão. Ao outro lado do túnel, o passageiro receberá uma mensagem amigável e verde brilhante, caso passe. Se o sistema não reconhecer ou suspeitar de uma pessoa, ela receberá uma mensagem vermelha. Outro exemplo é o CaliBurger, na California. O restaurante instalou sistemas nos locais de pedido. O software reconhece as pessoas registradas no seu sistema, ativa suas contas, mostra as refeições favoritas e sugere pedidos. Os clientes também têm possibilidade de escolher pagar com reconhecimento facial ao invés de pagamento do cartão.

De onde vêm os erros?

As raízes dessas falhas da tecnologia são diversas e não encontradas em parâmetros técnicos, conforme Jacky Alciné já mencionou. Os departamentos de pesquisa e desenvolvimento das empresas de tecnologia são lugares onde as desigualdades sociais também se reproduzem, como é em outros espaços sociais. As empresas não têm incentivos para programar softwares preconceituosos, mas ainda assim ele entram nos seus códigos.

Um algoritmo de um software de reconhecimento facial não é inteligente per si, ele precisa do que é chamado de aprendizado de máquina. O software aprende a partir da coleta de uma base de dados muito grande e assim consegue detectar a diferença entre uma face humana e a de um porco, por exemplo. A medida em que o treinamento é feito por pessoas da área da tecnologia que são na grande maioria homens brancos e de classes médias, há uma enorme falta de diversidade nessa área o que é transmitido no código do reconhecimento facial. A pesquisadora Silvana Bahia da ONG Olabi, com sede no Rio de Janeiro, explica “[...] o algoritmo é uma receita, é um comando que a máquina segue. Para ele seguir esse comando, ele consulta um banco de dados. Se esse dado tem viés de raça e de gênero, você tá excluindo muita gente desse jogo. Temos muitos exemplos que mostram que quando não tem diversidade na produção dessas tecnologias, sobretudo dessa automatização da vida – já que estamos vivendo uma automatização da vida -, você acaba deixando muita gente de fora e, ao mesmo tempo, aumenta as desigualdades.” Uma pesquisa do Pretalab, projeto do Olabi e Thoughtworks, baseado num questionário com 693 pessoas da área da tecnologia, mostrou resultados surpreendentes. Apenas 1/3 dos profissionais de tecnologia e inovação são mulheres e pessoas negras. Lembrando que no Brasil 54% da população brasileira é formada por pessoas negras/pretas e pardas.

Como combater

A pesquisadora e ativista Joy Buolamwini salientou em um TED-Talks, que é importante se perguntar quem codifica, como codificamos e porque codificamos. Sua intenção é sensibilizar para a ausência de mulheres negras no desenvolvimento de tecnologia com impacto social, para a falta de reflexão sobre os algoritmos. Segundo ela, nós precisamos mudar a relação de dominação dos homens brancos, e colocar no jogo outros grupos de gênero e raça diferentes nas empresas da tecnologia. Só com mais diversidade nos departamentos de pesquisa e desenvolvimento, é possivel que a diversidade da sociedade seja representada nos algoritmos. Isso é necessário para evitar reestabelecer e reforçar injustiças existentes dentro das novas tecnologias. Visto que a grande maioria de empresas de tecnologia são lideradas por homens brancos, e as diretorias dessas empresas são os que tomam decisões estratégias, é ainda mais importante que consigamos mais diversidade nesse tema. Ao mesmo tempo é preciso fomentar e animar, especialmente mulheres negras para embarcar no mundo da programação e desenvolvimento de software, assim como derrubar as barreiras artificiais existentes para mulheres negras.

Buolamwini propõe construir plataformas para identificação desses preconceitos, nas quais experiências são coletadas e o software existente é fiscalizado. O Pretalab é uma das propostas que segue o que Buolamwini menciona. Trata-se de uma pesquisa sobre raça e gênero na tecnologia e de uma plataforma na qual perfis de programadoras negras são apresentados. A ideia é aproximar os recrutadores dessas potenciais candidatas. Como as autoras do estudo afirmam: “Em um mundo cada vez mais digital, manipular as ferramentas da tecnologia e inovação é dominar as linguagens do futuro. É fazer parte da construção não apenas de produtos, mas da solução de problemas [...]”. Sil Bahia ressalta que o Olabi nasceu com a provocação de pensar sobre o que mudaria quando pessoas diferentes podem produzir tecnologia:“O que muda quando uma pessoa trans, uma mulher negra, um homem gay, um senhor idoso [produzem tecnologia], qual é a diferença?”.

Um outro exemplo de enfrentamento dos lados negativos do reconhecimento facial, pode ser encontrado ironicamente em San Francisco, local de nascimento do Sillicon Valley e epicentro da expansão das novas tecnologias. Lá o uso da tecnologia foi proibido pela polícia e orgãos municipais no dia 14 de maio de 2019, numa votação no Conselho de Supervisores do município com uma maioria de oito a um. Grupos da sociedade civil tinham denunciado que um abuso potencial do reconhecimento facial poderia ser um passo para se tornar um estado de vigilância. Logo que a lei passou outros municípios como, por exemplo, Oakland seguiram a decisão de San Francisco. Segundo um relatório da Universidade de Georgetown de 2016, 16 estados permitem que o FBI (Federal Bureau of Investigation) use a tecnologia de reconhecimento facial para comparar os rostos de suspeitos de crimes com a carteira de motorista e as fotos de identificação, criando uma linha virtual de residentes do estado. Ao mesmo tempo, os departamentos de polícia estaduais e locais estão construindo seus próprios sistemas de reconhecimento facial, muitos deles mais avançados que os do FBI. Decisões como a de San Francisco que preservam a privacidade poderiam servir como exemplo para outras cidades, mostrando que com vontade política o legislador ainda tem capacidade de agir e o tempo para agir é agora. Por outro lado, Sil Bahia questiona sobre a eficiência de criação de leis que deem conta de regularizar tecnologias preconceituosas. Para ela a saída passa por estimular a participação popular em dialógos com empresas e governos. Alguns já estão acontecendo, mas seria preciso democratizá-los. Segundo ela,os efeitos sociais da tecnologia estão sendo discutidos apenas em bolhas e de forma centralizada.

Previsão e Conclusão

Cenários de grande perda de privacidade nos espaços públicos não estão muito distantes, como mostra o exemplo da China citado acima com o Crédito Social e o da Grã-Bretanha. Na Inglaterra, um homem foi multado por “comportamento desordeiro”, porque cobriu sua face nas ruas para evitar ser filmado pelas câmeras de reconhecimento facial. O software usado em Londres foi desenvolvido pela empresa japonesa NEC e se chama NeoFace. A empresa divulga a capacidade de seu software de combinar imagens de câmeras já instaladas em tempo real – equipamento já instalado para a polícia de Londres. A cidade tem aproximadamente 500.000 câmeras de monitoramento. Quem se movimenta na rua é gravado cerca de 300 vezes por dia. O reconhecimento facial é só uma das maneiras de identificação com dados biométricos. O Departamento de Defesa dos Estados Unidos afirmou que pode identificar pessoas até pelo batimento cardíaco e a empresa Faception, de TelAviv, pretende que a partir do seu software de reconhecimento facial possam presumir o caráter de uma pessoa, além de características como QI, se é terrorista ou com tendências de pedofilia, por exemplo.

Há semelhanças entre essas previsões automatizadas e a ideia de que as câmeras de reconhecimento facial usam inteligência artificial para classificar automaticamente certos comportamentos como "suspeitos", "perigosos" ou "violentos".

Evitar a proliferação do uso de reconhecimento facial nos espaços públicos do Brasil será díficil, dado que seu uso já começou e está continuando. Não obstante, é importante descentralizar as discussões sobre o viés nas tecnologias. Infelizmente, este debate está presente apenas junto a um grupo seleto de pessoas. “Acho que é importante demais descentralizar essa discussão, porque todas as pessoas precisam entender os perigos, os prós e os contras disso tudo”, afirmou Sil Bahia. A partir de discussões mais descentralizadas é possível formular críticas ao potencial discriminador das tecnologias, e passar a baseá-las nos direitos humanos, além de propor ideias para regulação como há em São Francisco.

[1]São os artigos 12, 13 e 20 dos Direitos Humanos “Declaração dos Direitos Humanos:

Artigo 13: Direito à liberdade de movimento

1. Todo ser humano tem direito à liberdade de movimento e residência dentro das fronteiras de cada Estado.

2. Todo ser humano tem o direito de deixar qualquer país, inclusive o próprio, e a este regressar. ”